核心提示

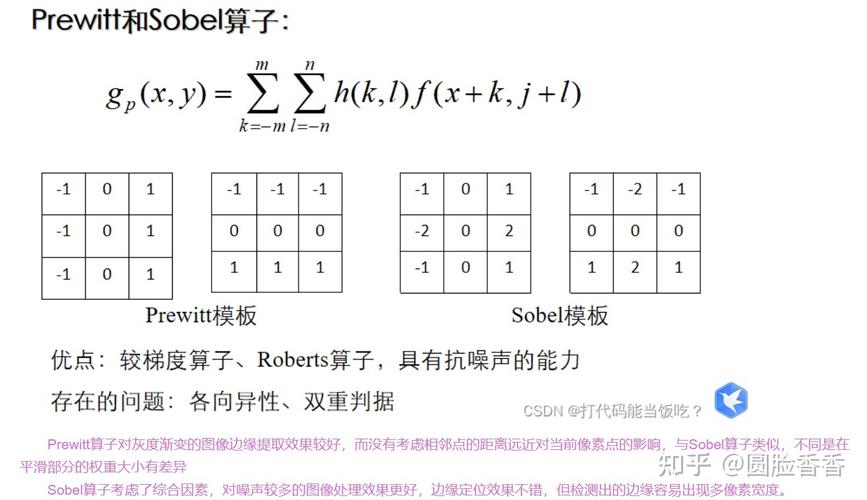

近5年的图像处理研究,深度学习,特别是卷积神经网络和Transformer架构,是绝对的核心,以下列表将重点放在这些奠基性和开创性的工作上。

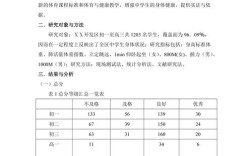

深度学习基础架构

这些是构建现代图像处理模型的基石,几乎所有后续工作都基于或改进了它们。

a) Transformer在视觉领域的应用

Transformer最初在NLP领域取得成功,其“自注意力”机制彻底改变了视觉领域。

-

An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

-

作者: Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, et al. (Google Research)

(图片来源网络,侵删)

(图片来源网络,侵删) -

年份: 2025 (NeurIPS 2025)

-

核心贡献:

- 首次成功地将纯Transformer架构(不含CNN卷积核)应用于大规模图像识别任务。

- 证明了Vision Transformer (ViT) 在足够大的数据集上预训练后,其性能可以超越当时最先进的CNN模型。

- 开创了"用Transformer做CV"的全新范式,后续的Swin Transformer, MAE等工作都基于此。

-

为什么重要: 它打破了CNN在视觉领域的长期统治地位,为图像分类、目标检测、分割等任务提供了全新的、更强大的模型设计思路。

-

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

(图片来源网络,侵删)

(图片来源网络,侵删) -

作者: Ze Liu, Yutong Lin, Yue Cao, Han Hu, Yixuan Wei, et al. (Microsoft Research)

-

年份: 2025 (ICCV 2025 Best Paper)

-

核心贡献:

- 解决了ViT计算复杂度高且难以处理高分辨率图像的问题。

- 引入了滑动窗口和窗口注意力机制,使得模型可以在不重叠的局部窗口内计算自注意力,大大降低了计算量。

- 构建了层次化的特征图(类似CNN),使其能够无缝替换CNN骨干网络,用于下游任务(如检测、分割)。

-

为什么重要: Swin Transformer成为了继ResNet之后,最主流、最强大的通用视觉骨干网络,是近两年无数SOTA(State-of-the-Art)模型的基础。

b) CNN的持续演进

尽管Transformer崛起,但CNN凭借其平移不变性和局部感受野等优良特性,依然是重要的研究基础。

- EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

- 作者: Mingxing Tan, Quoc V. Le (Google Brain)

- 年份: 2025 (ICML 2025)

- 核心贡献:

- 提出了一种复合缩放方法,均衡地调整网络的深度、宽度和分辨率。

- 之前的缩放方法通常只关注其中一两个方面,导致效率低下,EfficientNet通过一个复合系数,系统地搜索最优的模型配置。

- 为什么重要: 在不显著增加计算成本的情况下,实现了精度的巨大飞跃,其提出的

EfficientNet-B0到B7系列模型,在效率和精度之间取得了极佳的平衡,至今仍是许多资源受限场景下的首选。

图像生成与编辑

这是近年来最火爆、进展最快的领域之一,从GANs到Diffusion Models。

a) 生成对抗网络

- StyleGAN: Analyzing and Improving the Image Quality of Style-Based Generative Adversarial Networks

- 作者: Tero Karras, Samuli Laine, Miika Aittala, Jaakko Lehtinen, Timo Aila (NVIDIA)

- 年份: 2025 (CVPR 2025)

- 核心贡献:

- 引入了风格混合和自适应实例归一化技术,实现了对生成图像风格和内容进行精细、解耦的控制。

- 通过渐进式增长训练,生成了当时最高质量、最逼真的人脸图像。

- 为什么重要: StyleGAN系列(StyleGAN, StyleGAN2, StyleGAN3)成为了高质量图像生成的事实标准,被广泛应用于艺术创作、数据增强、虚拟人等领域。

b) 扩散模型

Diffusion Models目前是生成模型领域SOTA的王者,其生成的图像质量和多样性超越了GANs。

- High-Resolution Image Synthesis with Latent Diffusion Models

- 作者: Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, Björn Ommer (LMU Munich / RunwayML)

- 年份: 2025 (CVPR 2025)

- 核心贡献:

- 提出了潜在扩散模型,它不是在高维像素空间中进行耗时的去噪,而是在一个低维的潜在空间中进行操作,极大地提高了计算效率。

- 结合了U-Net架构和交叉注意力机制,实现了强大的条件图像生成能力。

- 为什么重要: 这是引爆AIGC(人工智能生成内容)浪潮的关键工作,Stable Diffusion模型就是基于LDM构建的,它使得在消费级显卡上运行高质量的文本到图像生成成为可能,对整个行业产生了颠覆性影响。

图像分割

图像分割是理解图像内容的关键任务,包括语义分割和实例分割。

-

Mask R-CNN

-

作者: Kaiming He, Georgia Gkioxari, Piotr Dollár, Ross Girshick (Facebook AI Research)

-

年份: 2025 (但影响力持续至今,是近5年无数工作的基础)

-

核心贡献:

- 在Faster R-CNN的基础上,增加了一个并行的分支用于预测每个感兴趣区域的掩码。

- 实现了实例分割(区分同一类别的不同实例)和 bounding box的同步高质量预测。

-

为什么重要: Mask R-CNN是实例分割领域里程碑式的工作,其设计思想(如RoIAlign)被后续几乎所有检测和分割模型所借鉴。

-

Segment Anything (SAM)

-

作者: Nikhil Ravi, Xiaoxiao Guo, Kiran Vodrahalli, Yuhao Zhou, Justin Gilmer, et al. (Meta AI)

-

年份: 2025 (arXiv预印本)

-

核心贡献:

- 提出了一个零样本的通用图像分割模型,它不需要针对特定任务进行微调,就能对图像中的任何物体进行分割。

- 模型由一个强大的图像编码器、一个提示编码器和一个轻量级掩码解码器组成,支持点、框、文本等多种交互式提示。

-

为什么重要: 它首次将图像分割推向了“基础模型”的时代,极大地降低了分割任务的应用门槛,并为分割任务提供了新的、统一的范式。

图像复原与超分辨率

旨在修复低质量图像,去噪、去模糊、去雨、超分辨率等。

- BasicVSR: A Good Baseline for Video Super-Resolution

- 作者: Wei Ning, Juncheng Li, Yawei Li, Zongming Guo (Nankai University)

- 年份: 2025 (ECCV 2025)

- 核心贡献:

- 提出了一个简单而有效的视频超分辨率基线模型。

- 核心思想是利用对齐和聚合:先对齐相邻帧的信息,然后聚合这些信息来重建当前帧的细节。

- 为什么重要: BasicVSR及其改进版(BasicVSR++, IconVSR)在视频超分辨率领域取得了巨大成功,证明了简单有效的模块设计可以超越复杂的结构,成为后续许多工作的基础。

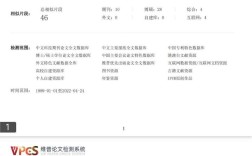

如何查找最新文献?

除了阅读上述经典综述,您还可以通过以下途径追踪最新进展:

-

顶级会议:

- CVPR (IEEE Conference on Computer Vision and Pattern Recognition): 规模最大,录用率最低,影响力最大。

- ICCV (IEEE International Conference on Computer Vision): 三年一届,规模与CVPR相当。

- ECCV (European Conference on Computer Vision): 三年一届,欧洲主办,水平同样顶尖。

- NeurIPS (Conference on Neural Information Processing Systems): 机器学习领域的顶级会议,越来越多与CV相关的深度学习工作在此发表。

-

预印本平台:

- arXiv.org: 计算机视觉与模式识别领域的论文绝大多数都会先在这里发布,关注

cs.CV(Computer Vision and Pattern Recognition) 分类。

- arXiv.org: 计算机视觉与模式识别领域的论文绝大多数都会先在这里发布,关注

-

文献综述:

定期搜索 "survey" 或 "review" 加上您感兴趣的关键词(如 "Transformer in Vision", "Diffusion Models Survey", "Image Segmentation Review"),可以快速了解一个方向的完整脉络。

希望这份列表能为您的研究或学习提供一个良好的起点!